Nvidia Corporation, plus communément appelée Nvidia, est une entreprise technologique américaine constituée dans le Delaware et dont le siège social se trouve à Santa Clara, en Californie. Nvidia conçoit des processeurs graphiques pour les jeux vidéo et les marchés professionnels, ainsi que des systèmes sur puce (SoC) pour les marchés de l’informatique mobile et automobile. Sa ligne de produits phare GeForce est en concurrence directe avec les produits Radeon d’AMD.

Outre la fabrication de GPU, Nvidia fournit des capacités de traitement parallèle aux chercheurs et aux scientifiques du monde entier, leur permettant d’exécuter efficacement des applications à haute performance. Plus récemment, elle s’est lancée sur le marché de l’informatique mobile, où elle produit des processeurs mobiles Tegra pour les consoles de jeu, les tablettes, les systèmes de divertissement embarqués et les systèmes de navigation autonomes. Depuis 2014, Nvidia s’est donc transformée en une entreprise axée sur quatre marchés : les jeux, la visualisation professionnelle, les centres de données et l’intelligence artificielle, ainsi que l’automobile.

Histoire de Nvidia

Nvidia a été fondée en 1993 par Jen-Hsun Huang, Chris Malachowsky et Curtis Priem. Les trois cofondateurs de la société ont émis l’hypothèse que la bonne direction pour l’informatique serait le traitement graphique accéléré, estimant que ce modèle d’informatique pourrait résoudre des problèmes que l’informatique générale ne pourrait pas résoudre. Ils ont également noté que les jeux vidéo font partie des problèmes les plus complexes sur le plan informatique et qu’ils représentent un volume de ventes incroyablement élevé.

D’une petite entreprise de jeux vidéo à un géant de l’intelligence artificielle

L’entreprise est née avec un capital de départ de 40 000 dollars. Elle n’avait pas de nom au départ et les cofondateurs nommaient tous leurs fichiers NV, comme dans “next version” (prochaine version). La nécessité d’incorporer la société a poussé les cofondateurs à réviser tous les mots comportant ces deux lettres, ce qui les a conduits à “invidia”, le mot latin pour “envie”.

Le lancement de RIVA TNT en 1998 a consolidé la réputation de Nvidia en matière de développement d’adaptateurs graphiques. Fin 1999, Nvidia a lancé le GeForce 256 (NV10), qui a notamment introduit la transformation et l’éclairage (T&L) au niveau du consommateur dans le matériel 3D. Fonctionnant à 120 MHz et doté de quatre lignes de pixels, il mettait en œuvre une accélération vidéo avancée, une compensation de mouvement et un mélange matériel de sous-images. Le GeForce a largement surpassé les produits existants.

Grâce au succès de ses produits, Nvidia a remporté le contrat de développement du matériel graphique de la console de jeu Xbox de Microsoft, ce qui lui a valu une avance de 200 millions de dollars. Toutefois, ce projet a accaparé bon nombre de ses meilleurs ingénieurs, qui ont dû se consacrer à d’autres projets. À court terme, cela n’a pas eu d’importance et le GeForce2 GTS a été livré au cours de l’été 2000. En décembre 2000, Nvidia a conclu un accord en vue d’acquérir les actifs intellectuels de son seul rival, 3dfx, un pionnier de la technologie graphique 3D grand public qui a dominé le secteur du milieu des années 1990 jusqu’en 2000. Le processus d’acquisition s’est achevé en avril 2002.

En juillet 2002, Nvidia a acquis Exluna pour un montant non divulgué. Exluna était responsable de la création de plusieurs outils de rendu logiciels. Plus tard, en août 2003, Nvidia a acquis MediaQ pour environ 70 millions de dollars. Le 22 avril 2004, elle a également acquis iReady, un fournisseur de solutions de délestage TCP/IP et iSCSI à haute performance.

Le succès de Nvidia sur le marché des jeux vidéo est tel qu’en décembre 2004, il est annoncé qu’elle assistera Sony dans la conception du processeur graphique RSX de la PlayStation 3, la console de jeux vidéo de nouvelle génération de la firme japonaise qui a la lourde tâche de réitérer le succès de son prédécesseur à succès.

En décembre 2006, Nvidia a reçu des citations à comparaître du ministère américain de la justice concernant d’éventuelles violations de la législation antitrust dans le secteur des cartes graphiques. À l’époque, AMD était devenu un rival majeur, suite à l’achat d’ATI par ce dernier. Depuis lors, AMD et Nvidia sont les seuls fabricants de cartes graphiques pour jeux, sans parler des puces intégrées d’Intel.

Forbes a désigné Nvidia comme la meilleure entreprise de 2007 en citant ses réalisations au cours des cinq dernières années. Le 5 janvier 2007, Nvidia a annoncé qu’elle avait finalisé l’acquisition de PortalPlayer, Inc. En février 2008, Nvidia a acquis Ageia, développeur du moteur physique PhysX et de l’unité de traitement physique qui fait fonctionner ce moteur. Nvidia a annoncé qu’elle prévoyait d’intégrer la technologie PhysX dans ses futurs produits GeForce GPU.

Nvidia a été confrontée à une difficulté majeure en juillet 2008, lorsqu’elle a subi une perte de revenus d’environ 200 millions après qu’il a été rapporté que certains chipsets mobiles et GPU produits par la société présentaient des taux de défaillance anormaux dus à des défauts de fabrication. En septembre 2008, Nvidia a fait l’objet d’un recours collectif de la part des personnes concernées, alléguant que des GPU défectueux avaient été incorporés dans certains modèles d’ordinateurs portables fabriqués par Apple, Dell et HP. Le feuilleton a pris fin en septembre 2010, lorsque Nvidia a conclu un accord selon lequel les propriétaires des ordinateurs portables concernés seraient remboursés pour les réparations ou, dans certains cas, le remplacement du produit.

En novembre 2011, Nvidia a lancé son système de puce Tegra 3 ARG pour les appareils mobiles, après l’avoir dévoilé au Mobile World Congress. Nvidia a affirmé que la puce comportait le premier processeur mobile à quatre cœurs. En janvier 2013, Nvidia a dévoilé le Tegra 4, ainsi que le Nvidia Shield, une console de jeu portable basée sur Android et alimentée par le nouveau processeur.

Le 6 mai 2016, Nvidia a dévoilé les cartes graphiques GeForce GTX 1080 et 1070, les premières basées sur la microarchitecture Pascal. Nvidia affirme que les deux modèles surpassent son modèle Titan X basé sur Maxwell. Ces cartes sont dotées de mémoire GDDR5X et GDDR5 respectivement, et utilisent un processus de fabrication de 16nm.

En mai 2017, Nvidia a annoncé un partenariat avec Toyota Motor Corp, dans le cadre duquel cette dernière utilisera la plateforme d’intelligence artificielle Drive X-series de Nvidia pour ses véhicules autonomes. En juillet 2017, Nvidia et le géant chinois de la recherche Baidu, Inc. ont annoncé un partenariat d’envergure en matière d’intelligence artificielle qui comprend l’informatique en nuage, la conduite autonome, les appareils grand public et le cadre d’intelligence artificielle de Baidu, PaddlePaddle.

Nvidia GeForce et Nvidia Pascal, qui dominent l’industrie du jeu vidéo

NvidiaGeForce est le nom commercial des cartes graphiques basées sur des unités de traitement graphique (GPU) développées par Nvidia depuis 1999. À ce jour, la série GeForce a connu seize générations depuis sa création. Les versions de ces cartes destinées aux utilisateurs professionnels sont appelées Quadro et comprennent certaines caractéristiques différentielles au niveau du pilote. La concurrence directe de GeForce est AMD avec ses cartes Radeon.

Pascal est le nom de code de l’avant-dernière microarchitecture GPU développée par Nvidia pour le marché des jeux, qui succède à l’architecture Maxwell. L’architecture Pascal a été introduite pour la première fois en avril 2016 avec le lancement de la Tesla P100 pour les serveurs le 5 avril 2016. Par la suite, Pascal a été utilisé principalement dans la série GeForce 10, les GeForce GTX 1080 et GTX 1070 étant les premières cartes de jeu commercialisées avec cette architecture, respectivement le 17 mai 2016 et le 10 juin 2016. Pascal est fabriqué à l’aide du processus FinFET 16 nm de TSMC, ce qui lui permet d’offrir une efficacité énergétique et des performances bien plus élevées que Maxwell, qui a été fabriqué à l’aide du processus FinFET 28 nm.

L’architecture Pascal est organisée en interne en ce que l’on appelle un multiprocesseur de streaming (SM), des unités fonctionnelles composées de 64 cœurs CUDA, eux-mêmes divisés en deux blocs de traitement de 32 cœurs CUDA chacun et accompagnés d’un tampon d’instructions, d’un planificateur warp, de 2 unités de mappage de textures et de 2 unités de répartition. Ces unités SM sont l’équivalent des CU d’AMD.

L’architecture Pascal de Nvidia est conçue pour être l’architecture la plus efficace et la plus avancée dans le monde du jeu. L’équipe d’ingénieurs de Nvidia a déployé beaucoup d’efforts pour créer une architecture GPU capable d’atteindre des vitesses d’horloge très élevées tout en maintenant une faible consommation d’énergie. Pour y parvenir, tous les circuits ont été soigneusement conçus et optimisés, ce qui a permis à Pascal d’atteindre des vitesses d’horloge 40% plus élevées que Maxwell, ce qui est beaucoup plus élevé que ce que le processus 16nm aurait permis sans toutes les optimisations de conception.

La mémoire est un élément clé de la performance d’une carte graphique, la technologie GDDR5 a été annoncée en 2009, elle était donc déjà obsolète pour les cartes graphiques les plus puissantes à l’époque. Pascal supporte donc la mémoire GDDR5X, qui était la norme d’interface mémoire la plus rapide et la plus avancée de l’histoire au moment du lancement de ces cartes graphiques, atteignant des vitesses de transfert allant jusqu’à 10 Gbps. La mémoire GDDR5X permet également à la carte graphique de consommer moins d’énergie que la mémoire GDDR5, puisque la tension de fonctionnement est de 1,35 V, contre 1,5 V ou plus pour les puces GDDR5 plus rapides. Cette réduction de la tension se traduit par une fréquence de fonctionnement 43% plus élevée pour une même consommation d’énergie.

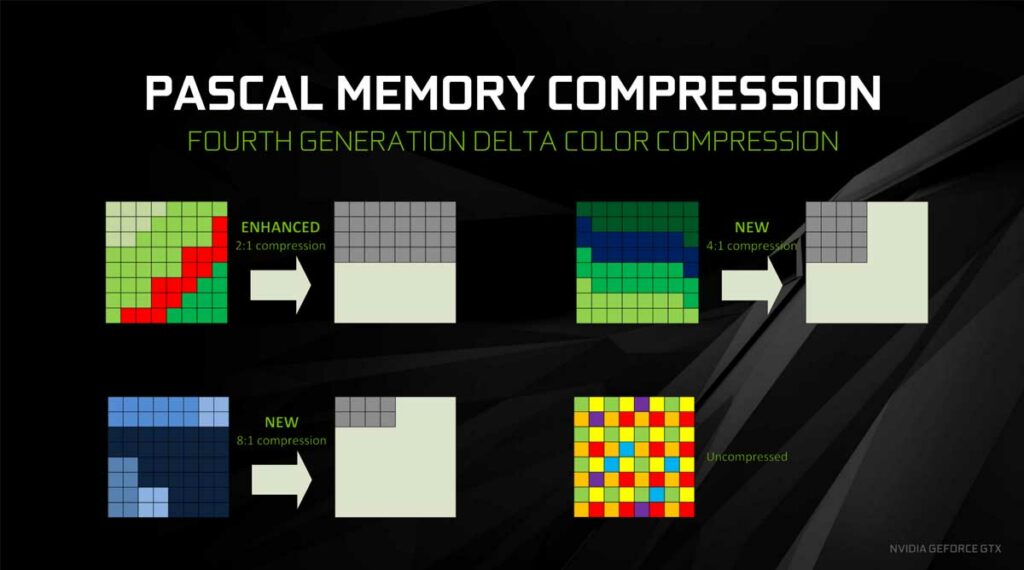

Une autre innovation majeure de Pascal réside dans les techniques de compression de la mémoire qui réduisent les besoins en bande passante du GPU. Pascal inclut la quatrième génération de la technologie de compression des couleurs delta. Avec la compression delta des couleurs, le GPU analyse les scènes pour calculer les pixels dont les informations peuvent être compressées sans sacrifier la qualité de la scène. Alors que l’architecture Maxwell n’était pas en mesure de compresser les données relatives à certains éléments, tels que la végétation et les pièces de voiture dans le jeu Project Cars, Pascal est capable de compresser la plupart des informations relatives à ces éléments, ce qui le rend beaucoup plus efficace que Maxwell. Par conséquent, Pascal est capable de réduire de manière significative le nombre d’octets qui doivent être extraits de la mémoire. Cette réduction du nombre d’octets se traduit par une bande passante effective supplémentaire de 20 %, soit une augmentation de 1,7 fois de la bande passante avec l’utilisation de la mémoire GDDR5X par rapport à la mémoire GDDR5 et à l’architecture Maxwell.

Pascal offre également des améliorations significatives en matière de calcul asynchrone, ce qui est très important dans les charges de travail complexes d’aujourd’hui. Grâce à ces améliorations, l’architecture Pascal est plus efficace pour répartir la charge entre ses différentes unités SM, ce qui signifie qu’il n’y a pratiquement pas de cœurs CUDA inutilisés. Cela permet au GPU d’être beaucoup plus optimisé et de mieux utiliser toutes les ressources dont il dispose.

Le tableau suivant résume les principales caractéristiques de toutes les cartes GeForce basées sur la technologie Pascal.

| CARTES GRAPHIQUES NVIDIA GEFORCE PASCAL | ||||||

| Cœurs CUDA | Fréquence | Mémoire | Interface mémoire | Largeur de bande de la mémoire (GB/s) | TDP (W) | |

| NVIDIA GeForce GT1030 | 384 | 1468 | 2 GB GDDR5 | 64 bit | 48 | 30 |

| NVIDIA GeForce GTX1050 | 640 | 1455 | 2 GB GDDR5 | 128 bit | 112 | 75 |

| NVIDIA GeForce GTX1050Ti | 768 | 1392 | 4 GB GDDR5 | 128 bit | 112 | 75 |

| NVIDIA GeForce GTX1060 3 GB | 1152 | 1506/1708 | 3 GB GDDR5 | 192 bit | 192 | 120 |

| NVIDIA GeForce GTX1060 6 GB | 1280 | 1506/1708 | 6 GB GDDR5 | 192 bit | 192 | 120 |

| NVIDIA GeForce GTX1070 | 1920 | 1506/1683 | 8 GB GDDR5 | 256 bit | 256 | 150 |

| NVIDIA GeForce GTX1070Ti | 2432 | 1607/1683 | 8 GB GDDR5 | 256 bit | 256 | 180 |

| NVIDIA GeForce GTX1080 | 2560 | 1607/1733 | 8 GB GDDR5X | 256 bit | 320 | 180 |

| NVIDIA GeForce GTX1080 Ti | 3584 | 1480/1582 | 11 GB GDDR5X | 352 bit | 484 | 250 |

| NVIDIA GeForce GTX Titan Xp | 3840 | 1582 | 12 GB GDDR5X | 384 bit | 547 | 250 |

Intelligence artificielle et architecture Volta

Les GPU de Nvidia sont largement utilisés dans les domaines de l’apprentissage profond, de l’intelligence artificielle et de l’analyse accélérée des données massives. L’entreprise a développé une technologie GPU basée sur l’apprentissage profond afin d’utiliser l’intelligence artificielle pour résoudre des problèmes tels que la détection du cancer, les prévisions météorologiques et les voitures autopilotées, comme la célèbre Tesla.

L’objectif de Nvidia est d’aider les réseaux à apprendre à “penser”. Les GPU de Nvidia fonctionnent exceptionnellement bien pour les tâches d’apprentissage en profondeur, car ils sont conçus pour le calcul parallèle et gèrent bien les opérations vectorielles et matricielles qui prévalent dans l’apprentissage en profondeur. Les GPU de l’entreprise sont utilisés par des chercheurs, des laboratoires, des sociétés technologiques et des entreprises. En 2009, Nvidia a participé à ce que l’on a appelé le “big bang” de l’apprentissage profond, en combinant des réseaux neuronaux d’apprentissage profond avec les unités de traitement graphique de l’entreprise. La même année, Google Brain a utilisé les GPU de Nvidia pour créer des réseaux neuronaux profonds capables d’apprentissage automatique, et Andrew Ng a déterminé qu’ils pouvaient augmenter la vitesse des systèmes d’apprentissage profond d’environ 100 fois.

En avril 2016, Nvidia a présenté le supercalculateur DGX-1 basé sur un cluster de 8 GPU pour améliorer la capacité des utilisateurs à utiliser l’apprentissage profond en combinant les GPU avec des logiciels spécifiquement conçus. Nvidia a également développé les machines virtuelles Nvidia Tesla K80 et P100 basées sur les GPU, disponibles via Google Cloud, que Google a déployées en novembre 2016. Microsoft a ajouté des serveurs basés sur la technologie GPU de Nvidia dans un aperçu de sa série N, basée sur la carte Tesla K80. Nvidia s’est également associée à IBM pour créer un kit logiciel qui renforce les capacités d’IA de ses GPU. En 2017, des GPU Nvidia ont également été mis en ligne au RIKEN Centre for Advanced Intelligence Project pour Fujitsu.

Volta est le nom de code de la microarchitecture GPU la plus avancée que Nvidia ait jamais développée. Elle succède à l’architecture Pascal et a été annoncée dans le cadre d’une future feuille de route en mars 2013. L’architecture porte le nom d’Alessandro Volta, physicien, chimiste et inventeur de la batterie électrique. L’architecture Volta n’a pas encore atteint le secteur des jeux, bien qu’elle l’ait fait avec la carte graphique Nvidia Titan V destinée au grand public, qui peut également être utilisée dans les plates-formes de jeux.

La Nvidia Titan V est une carte graphique basée sur le noyau GV100 et trois piles de mémoire HBM2, le tout dans un seul boîtier. La carte dispose d’un total de 12 Go de mémoire HBM2 fonctionnant via une interface mémoire de 3072 bits. Son GPU contient plus de 21 millions de transistors, 5120 cœurs CUDA et 640 cœurs Tensor pour offrir 110 TeraFLOPS de performances d’apprentissage profond. Ses fréquences de fonctionnement sont de 1200 MHz en base et de 1455 MHz en mode turbo, tandis que la mémoire fonctionne à 850 MHz, offrant une bande passante de 652,8 Go/s. Une version CEO Edition a récemment été annoncée, qui augmente la mémoire à 32 Go.

La première carte graphique fabriquée par Nvidia avec l’architecture Volta a été la Tesla V100, qui fait partie du système Nvidia DGX-1. La Tesla V100 utilise le noyau GV100 qui a été lancé le 21 juin 2017. Le GPU Volta GV100 est construit sur un processus de fabrication FinFET de 12 nm, avec 32 Go de mémoire HBM2 capable de fournir jusqu’à 900 Go/s de bande passante.

L’architecture Volta se caractérise par le fait qu’elle est la première à inclure des Tensor Cores, des cœurs spécialement conçus pour offrir des performances d’apprentissage profond bien supérieures à celles des cœurs CUDA classiques. Un Tensor Core est une unité qui multiplie deux matrices FP16 4 × 4, puis ajoute une troisième matrice FP16 ou FP32 au résultat, à l’aide d’opérations d’addition et de multiplication fusionnées, ce qui donne un résultat FP32 qui peut éventuellement être ramené à un résultat FP16. Les noyaux tensoriels sont destinés à accélérer l’entraînement des réseaux neuronaux.

Volta est également doté de l’interface propriétaire avancée NVLink, un protocole de communication développé par Nvidia pour succéder à SLI, qui peut être utilisé pour les transferts de données et de codes de contrôle entre le CPU et les systèmes de processeurs basés sur le GPU uniquement. NVLink spécifie une connexion point à point avec des débits de données de 20 et 25 Gb/s par voie de données et par direction dans ses première et deuxième versions. Les débits totaux dans les systèmes réels sont de 160 et 300 Go/s pour la somme totale des flux de données d’entrée et de sortie du système. Les produits NVLink introduits à ce jour se concentrent sur l’espace d’application à haute performance, et bien qu’ils aient été introduits dans les jeux graphiques, leur utilisation devient de plus en plus restreinte.

Le tableau suivant résume les principales caractéristiques des cartes basées sur la technologie Volta :

| CARTES GRAPHIQUES NVIDIA VOLTA | |||||||

| Cœurs CUDA | Tensor Core | Fréquence | Mémoire | Interface mémoire | Largeur de bande de la mémoire (GB/s) | TDP (W) | |

| Tesla V100 | 5120 | 640 | 1465 | 32 GB HBM2 | 4.096 bit | 900 | 250 |

| GeForce Titan V | 5120 | 640 | 1200/1455 | 12 GB HBM2 | 3.072 bit | 652 | 250 |

| GeForce Titan V CEO Edition | 5120 | 640 | 1200/1455 | 32 GB HBM2 | 4.096 bit | 900 | 250 |

NVIDIA Turing et l’ouverture d’un tout nouveau marché avec RTX

Après le succès de Pascal, NVIDIA a lancé en 2018 Turing, une nouvelle architecture graphique qui a révolutionné l’ensemble du paysage des cartes graphiques, grâce à l’introduction de RTX. En gros, NVIDIA a mis sur le marché pour la première fois des technologies de ray tracing en temps réel, qu’ils ont combinées avec des technologies vraiment intéressantes et révolutionnaires que nous allons détailler pour vous ci-dessous.

Le ray tracing est une technique d’éclairage fondamentale dans le monde de l’animation 3D, pratiquement toute image générée par ordinateur qui se veut ultra-réaliste doit utiliser cette technologie, qui est simplement basée sur le traçage d’un grand nombre de rayons à partir de sources lumineuses, l’analyse du rebond de chacun d’entre eux vers le spectateur, et ainsi pouvoir donner des lumières, des reflets et des ombres en accord avec la réalité.

Comme nous l’avons dit, cette technique est utilisée depuis des années et est apparue dans les années 1970. Qu’est-ce que RTX a de si spécial ? C’est très simple : le ray tracing nécessite beaucoup d’efforts de calcul, ce qui explique pourquoi nous n’avons pas encore vu d’implémentations complexes en temps réel. En d’autres termes, le ray tracing était utilisé dans les films, les vidéos, etc… en d’autres termes, le contenu pré-rendu. Un jeu vidéo est rendu en temps réel, et là, le ray tracing était irréalisable. Jusqu’à l’arrivée de la technologie NVIDIA RTX, qui a permis à des caractéristiques matérielles spécifiques de commencer à la prendre en charge dans les jeux.

Au lieu du ray tracing, les jeux utilisaient et utilisent encore des techniques de tramage. NVIDIA a déclenché une révolution en introduisant cette technique, et les cartes graphiques AMD ainsi que les consoles de nouvelle génération ont suivi le mouvement.

Les deux principaux protagonistes de Turing sont les nouveaux types de cœurs inclus. En plus des cœurs CUDA traditionnels, deux cœurs fondamentaux ont été ajoutés :

- RT Cores : c’est là que se produit toute la magie du ray tracing en temps réel, car ce sont eux qui accélèrent ce processus. Fondamentalement, ils implémentent efficacement les opérations nécessaires pour calculer les réflexions et les illuminations du ray tracing. Ils sont tout nouveaux et constituent donc la première génération de ce type de cœur.

- Tensor Cores : dans ce cas, il s’agit d’une deuxième génération par rapport à ceux inclus dans Volta.

Mais ces deux types de cœurs ne deviennent pas pertinents par magie, il faut les exploiter correctement dans le développement d’applications et de jeux vidéo. Ont-ils réussi ?

Ray Tracing et DLSS, deux des innovations les plus importantes de ces dernières années

Avec l’arrivée de NVIDIA Turing, la société a continué à exploiter les capacités des nouveaux RT Cores et Tensor Cores introduits, avec l’avènement de son implémentation du ray tracing et de la technologie DLSS.

Le nouveau ray tracing en temps réel pour les jeux fonctionne principalement sous l’API DirectX Ray Tracing (DXR), lancée par Microsoft à la suite d’une collaboration avec Nvidia. Ainsi, tous les jeux utilisant déjà cette API (c’est-à-dire la plupart des titres) ont pu facilement adapter et intégrer cette technologie, ce qui s’est avéré payant en termes de réalisme dès le départ :

Parmi les titres notables qui supportent actuellement RTX, on peut citer les suivants :

- Cyberpunk 2077

- Fortnite

- Minecraft pour Windows 10 (certains d’entre vous seront peut-être surpris, mais il s’agit de l’une des implémentations les plus impressionnantes du Ray Tracing)

- Watch Dogs : Legion.

- Call of Duty : Modern Warfare

- Contrôle

- Wolfenstein : Youngblood

- Vampire : The Masquerade – Bloodlines 2

- Synchronisé hors planète

- Dying Light 2

- Quake 2 RTX

- Mechwarrior 5 : Mercenaries

- Deliver Us The Moon

- Justice

- Atomic Heart

- Battlefield V

- Metro Exodus

- Shadow of the Tomb Raider

- Final Fantasy XV

Le fait est que peu importe la vitesse à laquelle vous accélérez avec les RT Cores, les techniques de ray tracing restent extrêmement exigeantes. C’est pourquoi lorsque nous parlons de RTX, nous ne parlons pas seulement de ray tracing, mais aussi de la nouvelle technologie DLSS.

Deep Learning Super Sampling ou DLSS est également une innovation impressionnante sur le marché des cartes graphiques et des jeux. Il s’agit d’une technologie intelligente de remise à l’échelle qui permet à la carte graphique d’effectuer un rendu à une résolution inférieure à celle affichée à l’écran, mais sans perte de qualité visuelle.

Contrairement au redimensionnement normal, DLSS tire parti des cœurs tenseurs pour exécuter des algorithmes d’intelligence artificielle capables de “remplir” tous les pixels manquants avec précision. Ce résultat est obtenu parce que chaque jeu qui prend en charge DLSS est spécifiquement entraîné par des algorithmes d’apprentissage profond sur des superordinateurs. Ainsi, nous pourrions regarder un jeu qui est en fait rendu à 1440p ou à 1080p à 4K et remarquer à peine la différence.

Avec le DLSS, non seulement les performances augmentent considérablement, mais elles peuvent même parfois produire de meilleures images. Souvent, dans ce genre de situation, nous sommes confrontés à des concepts marketing qui ne sont pas très importants dans la pratique. Mais DLSS est vraiment une innovation brutale, et un support fondamental pour que le ray tracing fonctionne bien dans les jeux, car quel que soit le nombre de RT Cores utilisés, l’écart de performance est très important lorsque nous l’activons.

NVIDIA Ampere, un pas de plus

Deux ans après le lancement initial de RTX, NVIDIA a annoncé la deuxième architecture RTX, appelée Ampere. Cela signifiait essentiellement une forte augmentation des performances offertes, tant en termes de cœurs CUDA que de cœurs Tensor et de cœurs RT.

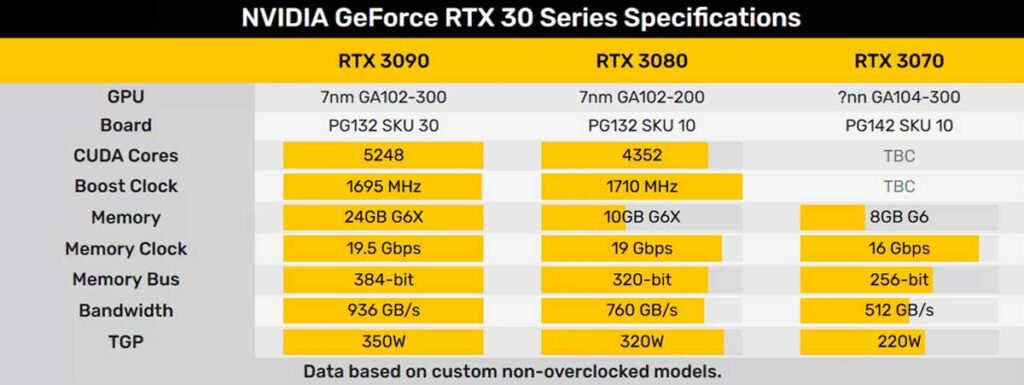

La nouvelle génération a apporté trois grandes bêtes, les RTX 3090, 3080 et 3070, dont les spécifications techniques sont énumérées ci-dessous :

Elles établissent de nouvelles normes de haute performance et font enfin du jeu Ultra 4K 60fps une réalité palpable, la RTX 3080 rendant possible de grandes performances à cette résolution, ce qui est également le cas de la 3070, bien que cette dernière soit plutôt la reine du 1440p 144fps.

Quant à la 3090, son augmentation de prix est bien plus importante que l’augmentation des fonctionnalités par rapport à la 3080, mais elle est rapidement devenue une excellente référence pour les utilisateurs qui avaient besoin de tirer parti de sa puissance brute et de sa quantité de mémoire, par exemple dans le cadre de travaux d’intelligence artificielle.

NVIDIA Ada Lovelace, la proposition 2023 et 2024

Fin 2022 arrive Ada Lovelace, l’architecture qui marquera sa feuille de route pour 2023 et 2024, puisqu’un successeur n’est pas attendu avant Ada Lovelace Next en 2025. Et avec elle, la RTX 4090, une carte graphique presque impossible à battre pour AMD et qui s’accompagne de technologies toujours plus nombreuses et plus performantes.

Autres technologies clés de NVIDIA

Jetons un coup d’œil à d’autres technologies logicielles qui, comme DLSS, sont ou ont été fondamentales pour la progression de l’entreprise ces dernières années et qui séduisent tant de joueurs.

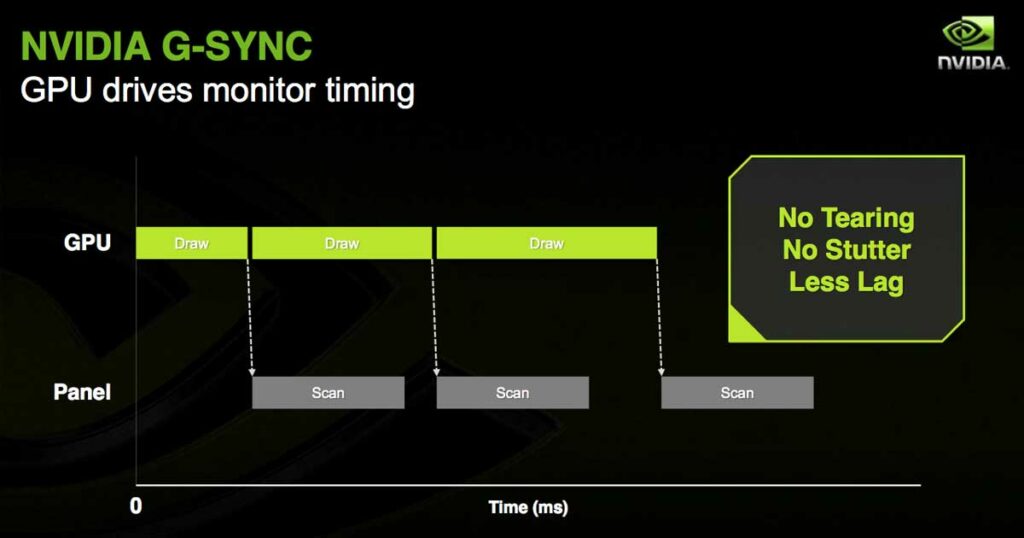

NVIDIA G-Sync, la fin des problèmes de synchronisation des images

G-Sync est une technologie propriétaire de synchronisation adaptative développée par Nvidia, dont l’objectif principal est d’éliminer les déchirures d’écran et le besoin d’alternatives logicielles telles que Vsync. G-Sync élimine les déchirures d’écran en forçant l’affichage à s’adapter au taux de rafraîchissement du périphérique de sortie, la carte graphique, plutôt que le périphérique de sortie ne s’adapte à l’affichage, ce qui entraîne des déchirures d’écran.

Pour qu’un moniteur prenne en charge G-Sync, il doit contenir un module matériel vendu par Nvidia. AMD a mis sur le marché une technologie similaire pour les écrans, appelée FreeSync, qui a la même fonction que G-Sync mais ne nécessite pas de matériel spécifique.

NvidiaG-Sync a fait l’objet de critiques en raison de sa nature propriétaire et du fait qu’elle est toujours promue alors qu’il existe des alternatives gratuites, telles que la norme VESA Adaptive-Sync, qui est une caractéristique optionnelle de DisplayPort 1.2a. Alors que FreeSync d’AMD est basé sur DisplayPort 1.2a, G-Sync nécessite un module fabriqué par Nvidia au lieu de l’habituel scaler à l’écran pour fonctionner correctement sur les cartes graphiques GeForce de Nvidia, prenant en charge les microarchitectures Kepler, Maxwell, Pascal et Volta.

À la suite de ces critiques, NVIDIA a adopté une nouvelle approche pour G-Sync, en commençant à prendre en charge la même norme VESA que la technologie ouverte AMD FreeSync, ne nécessitant plus l’implémentation matérielle coûteuse de la G-Sync traditionnelle.

Ainsi, le G-Sync tel que nous le connaissions est devenu le G-Sync Ultimate, et le nouveau G-Sync, moins cher, est appelé G-Sync Compatible.

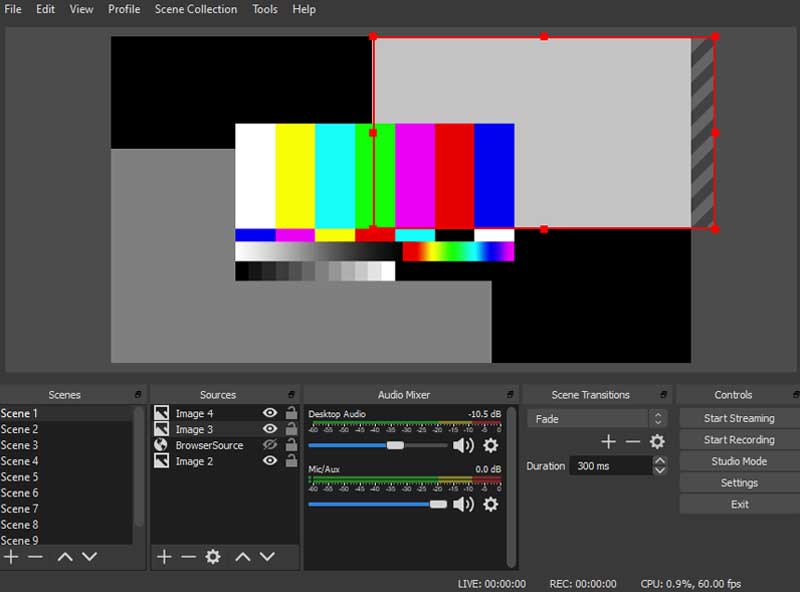

NVIDIA NVENC, l’encodeur propriétaire de la société

Lorsque nous parlons de rendu vidéo ou de streaming de jeux vidéo, il y a un aspect clé : l’encodeur ou le codeur que nous utilisons, qui sera essentiellement ce qui produit la sortie dans un format vidéo lisible, ou qui nous permet de regarder une vidéo en direct, avec les codecs et les formats appropriés.

Dans ce contexte, nous pouvons utiliser des encodeurs logiciels qui exploitent toute la puissance de notre CPU, ce qui a été l’approche la plus courante ces dernières années, ou nous pouvons utiliser un encodeur matériel, qui tire parti de l’accélération du GPU. NVENC est la solution de NVIDIA à cette question.

NVIDIA NVENC est une avancée impressionnante dans les technologies d’encodage.

Par exemple, en ce qui concerne le rendu et l’exportation de vidéos, NVENC offre des performances jusqu’à trois fois plus rapides et meilleures que l’accélération logicielle. En outre, cet encodeur propriétaire est nettement meilleur que les alternatives ouvertes telles qu’OpenCL, essentiellement parce qu’il tire pleinement parti de la technologie CUDA de NVIDIA.

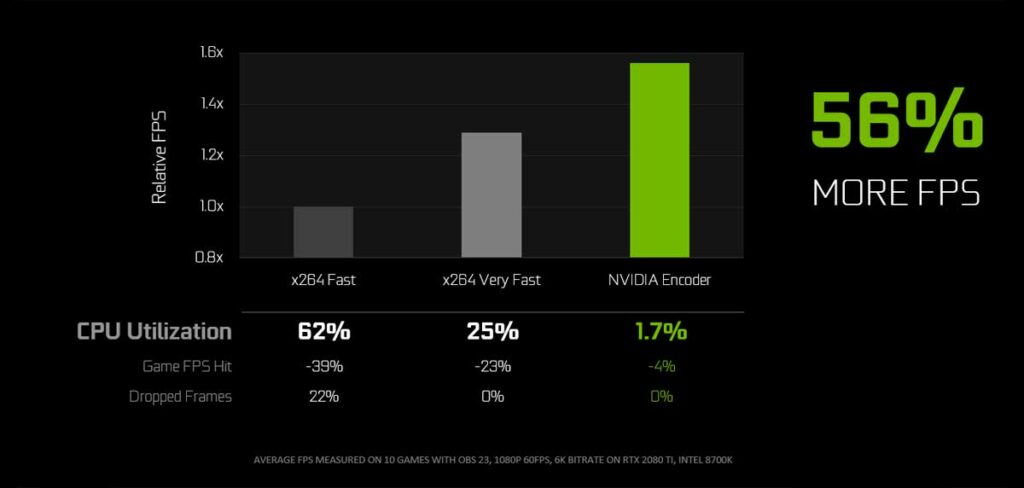

C’est tout aussi important, si ce n’est plus, pour le streaming de jeux, pour une raison très simple : lorsque vous diffusez un jeu avec un encodage logiciel, vous devez faire face à une augmentation considérable de la charge du processeur. Ce n’est pas un problème lors du rendu d’une vidéo, mais ici vous générez le contenu lui-même pendant que vous le diffusez, et une charge CPU élevée peut gravement affecter la fluidité. L’avantage du NVENC est que son impact sur les performances de jeu est en fait assez faible.

Selon les données de l’entreprise, mesurées sur 10 jeux différents, NVENC minimise la charge de l’unité centrale tout en parvenant à réduire de 56 % le nombre d’images par seconde, sans compromettre la qualité de la diffusion en continu.

Reflex, Studio et Omniverse Machinima

Les dernières technologies internes de NVIDIA comprennent Reflex, qui se concentre sur la réduction du délai entre les clics de souris et les changements à l’écran (essentiel dans les jeux), Omniverse Machinima, un outil puissant pour créer des histoires de jeux animées, et sa suite NVIDIA Broadcast, qui comprend des innovations passionnantes dans l’annulation du bruit :

Enfin, nous pourrions mentionner RTX I/O, mais ce n’est rien d’autre qu’une implémentation du DirecStorage de Microsoft.

Une autre technologie très spéciale est sans aucun doute NVIDIA GeForce NOW, qui vous permet de jouer à des jeux dans le cloud sans avoir besoin d’une carte graphique puissante et qui s’est avérée très performante.

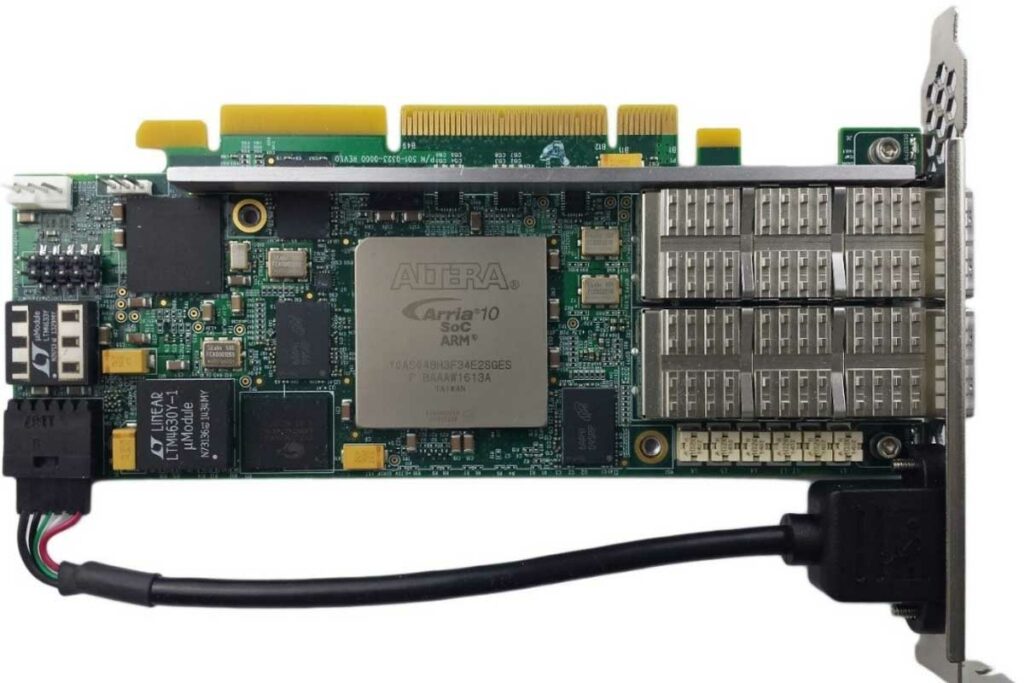

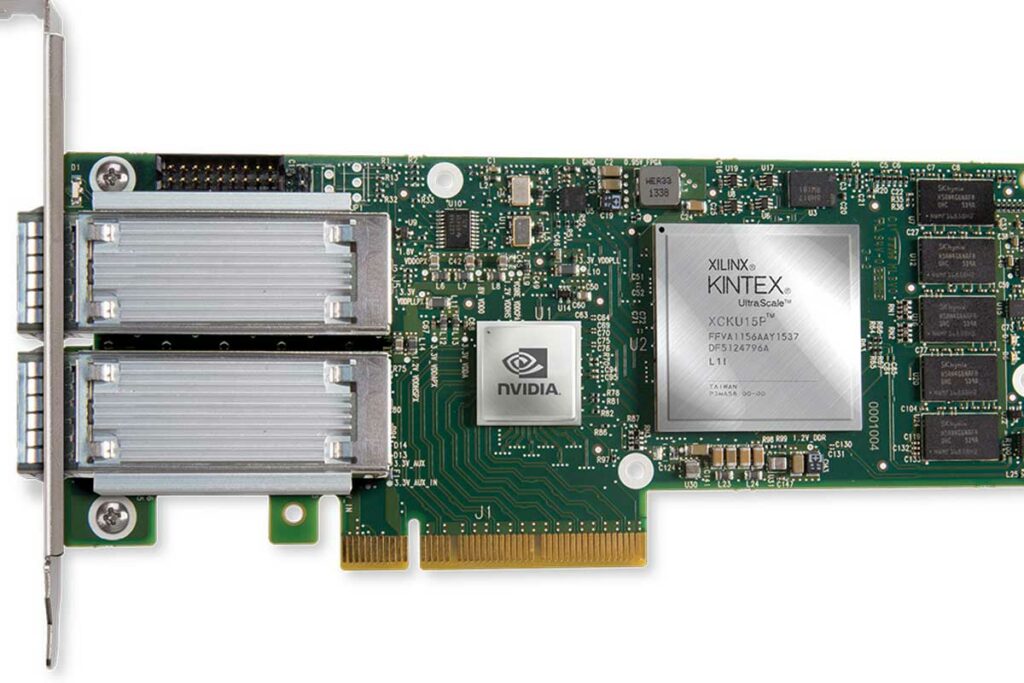

NVIDIA Mellanox, son entrée sur le marché des réseaux

2019, NVIDIA a racheté Mellanox, un important développeur de produits de réseau, dont les solutions de connectivité sont vraiment spéciales pour les centres de données : notamment pour l’interconnexion entre les serveurs qui doivent transférer une grande quantité d’informations, et surtout le faire assez rapidement pour ne pas être un fardeau ou un goulot d’étranglement, car ils vont passer entre différents processus de traitement entre toutes ces machines.

L’acquisition de cette société s’est avérée très payante pour NVIDIA, ses produits représentant près d’un tiers de ses revenus dans le domaine des centres de données.

Le boom économique post-pandémique

L’arrivée de la pandémie de coronavirus a durement touché de nombreuses entreprises, mais dans le segment technologique, c’est tout le contraire qui s’est produit. Pour NVIDIA, cela s’est traduit par une explosion de ses revenus : face aux défis informatiques posés par la pandémie, le recours accru aux services de travail à distance et l’utilisation accrue de l’internet et des PC en général ont entraîné une augmentation significative de la demande de GPU pour les serveurs et les PC.

Plus précisément, alors que NVIDIA frôlait les 3 milliards de dollars de chiffre d’affaires depuis le troisième trimestre 2019, il est passé à plus de 3,8 milliards de dollars au deuxième trimestre 2020, et à plus de 4,7 milliards de dollars au troisième trimestre. Cela montre clairement les dimensions de l’essor de son activité.

Les particuliers ont demandé beaucoup de GPU pour les jeux, les professionnels pour le télétravail, et tous sont devenus beaucoup plus connectés à l’internet, de sorte que beaucoup plus de GPU étaient nécessaires dans les serveurs. Quelle aubaine pour NVIDIA !

NVIDIA domine également dans le domaine de l’intelligence artificielle

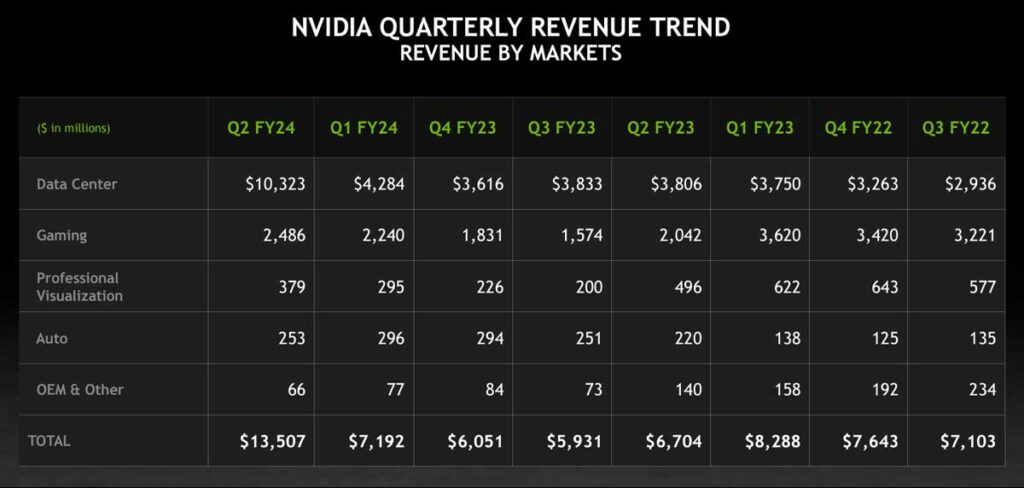

D’abord la pandémie, puis le boom du minage de crypto-monnaies… et juste au moment où l’on pensait que NVIDIA allait revenir à la normale, le boom de l’intelligence artificielle a fait son apparition. Au final, la morale est claire : pour cette entreprise, la normalité consiste à continuer à augmenter ses revenus et ses bénéfices sans discontinuer.

| Résultats financiers de NVIDIA pour le deuxième trimestre 2023 | |||||

| Q2 2023 | Q1 2023 | Q2 2022 | trimestrielle | d’une année sur l’autre | |

| Chiffre d’affaires | $13.5B | $7.2B | $6.7B | 0,88 | 1,01 |

| Marge brute | 70.1% | 64.6% | 43.5% | +5.5ppt | +26.6ppt |

| Marge opérationnelle | $6.8B | $2.1B | $499M | 2,18 | 12,63 |

| Bénéfice net | $6.1B | $2.0B | $656M | 2,03 | 8,43 |

| Bénéfice par action | $2.48 | $0.82 | $0.26 | 2,02 | 8,54 |

Les bénéfices de NVIDIA liés à l’IA ont été multipliés par huit en 2023, tout comme ses revenus, qui ont doublé. Ils ont atteint en un trimestre à la fois le bénéfice net et le chiffre d’affaires total de la même période en 2022. Brutal !

| Chiffre d’affaires de la plateforme au deuxième trimestre 2023 | |||||

| Q2 2023 | Q1 2023 | Q2 2022 | trimestrielle | d’une année sur l’autre | |

| Centres de données | $10,323M | $4,284M | $3,806M | 1,41 | 1,71 |

| Jeux vidéos | $2,486M | $2,240M | $2,042M | 0,11 | 0,21 |

| Visualisation professionnelle | $379M | $295M | $496M | 0,28 | -0,24 |

| Automobile | $253M | $296M | $220M | -0,15 | 0,15 |

| OEM & IP | $66M | $77M | $140M | -0,14 | -0,53 |

Précisément, tout vient du besoin de millions de cartes graphiques pour alimenter tous les besoins en modèles de traitement du langage naturel et de l’image tels que ceux que l’on trouve dans ChatGPT, Bing Chat ou Google Bard, et auxquels toutes les entreprises s’intéressent.

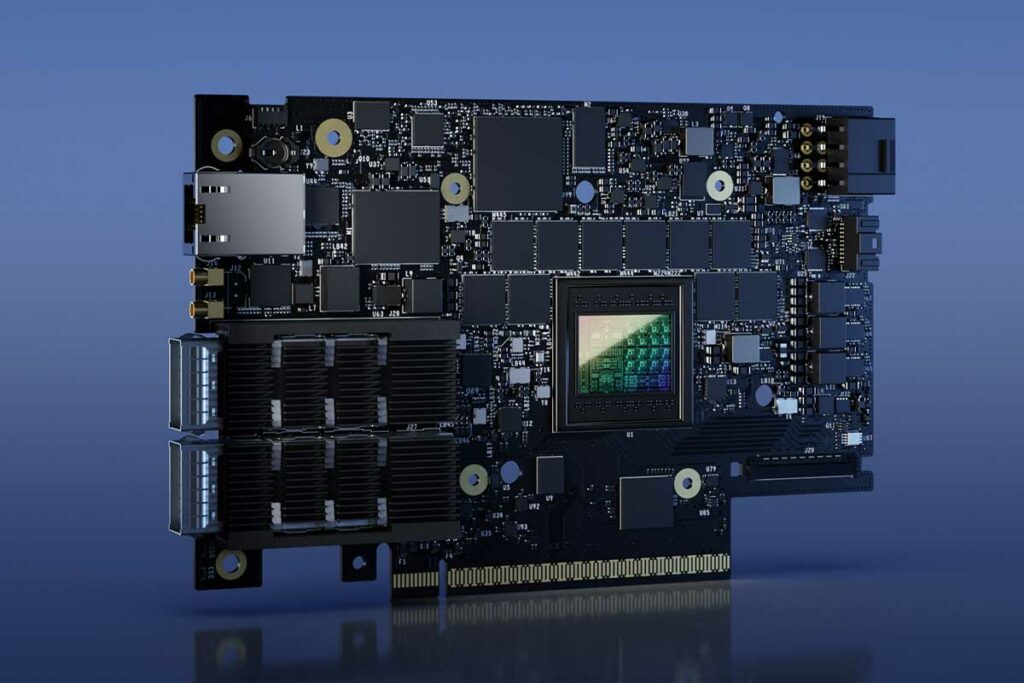

Le chemin à parcourir pour les DPU

Dans le monde du cloud, NVIDIA s’oriente également vers les DPU ou Data Processing Unit, des puces qui intègrent entre autres un CPU basé sur Arm. Il s’agit essentiellement de solutions qui intègrent des services avancés de connectivité (on reparle de Mellanox), de stockage et de sécurité qui sont clairement et spécifiquement conçus pour les serveurs.

Cette invention de NVIDIA vise fortement le cloud computing, où la combinaison traditionnelle CPU x86 et GPU est quelque peu insuffisante, et où avec l’intelligence artificielle, l’apprentissage automatique et le big data, qui sont bien plus que des concepts marketing, viennent de nouveaux besoins cruciaux en matière de traitement.

Une entreprise à l’avenir solide et puissant

Tout bien considéré, il est clair que NVIDIA a un avenir clair, fort, puissant et passionnant sur le marché de l’informatique. Elle a montré depuis longtemps que la concurrence d’Intel et d’AMD ne lui faisait pas de mal, et elle continue de surprendre tout le monde sur le marché des GPU et dans ses autres domaines d’activité.

Mais tout n’a pas été rose sur cette route : au milieu se trouvait l’achat raté d’Arm, bloqué par les régulateurs pour empêcher la formation d’une société si grande qu’elle deviendrait un monopole dangereux.

Voilà qui conclut notre article sur tout ce qu’il faut savoir sur Nvidia. N’oubliez pas que vous pouvez le partager sur les médias sociaux pour atteindre plus d’utilisateurs. Vous pouvez également laisser un commentaire si vous avez des suggestions ou quelque chose à ajouter.